넥시부터 테가까지 교육·건강관리 용 로봇 다수 개발

매사추세츠 캠브리지 = 이철현 기자

소셜 로봇들은 인공지능을 탑재하고 있어 원시적인 형태 나마 말귀를 알아듣고 자연어로 자기 의사도 표시하고 동물처럼 눈을 기민하게 움직입니다. 저는 지난달 17~21일 매세추세츠공과대학(MIT) 미디어연구소(Media Lab)을 방문했습니다. 미디어연구소는 보스턴 도심과 캠브리지 사이를 가로 지르는 찰스 강에 접한 와이즈너 건물에 들어있습니다. 이 건물에서 가장 매력적인 존재가 로봇들일 겁니다.

일부 인공지능 전문가는 인텔리전트 로봇을 가장 이상적인 인공지능이라고 합니다. 물론 주어는 로봇입니다. 인공지능이 인간 대신 일상의 업무나 과제를 능숙하게 처리하려면 물리적 실체를 가진 로봇과 결합해야 한다고 하네요. 일본과 미국에선 인공지능을 탑재한 휴머노이드 로봇 개발이 한창입니다. 특히 MIT 미디어연구소 개인로봇그룹은 소셜로봇 연구에 몰두하고 있습니다.

개인로봇그룹은 인간, 특히 어린이와 상호작용하며 언어 학습, 사회성 습득, 건강 관리 등 기능을 수행하는 소셜로봇을 다수 개발하고 있어요. 이 그룹에는 박혜원, 정수연, 이진주 연구원 등 한국 교포 3인방이 활약하고 있습니다.

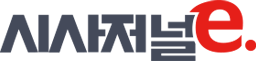

허거블은 건강관리, 교육, 사회적 소통 목적으로 개발된 캠패니언(친구) 로봇입니다. 신디아 브리질 MIT 교수가 총괄하는 미디어연구소 개인로봇그룹이 개발했어요. 이 로봇은 하늘색 곰 인형 모습을 하고 있습니다. 테디베어 곰인형 좋아하시는 분들은 남녀노소 할 거 없이 좋아할 만한 비쥬얼입니다. 허거블은 어린이가 사용하는 언어와 비언어 표현들, 즉 말과 행동을 이해하고 이에 맞춰 반응합니다. 곰인형이 말 귀를 알아듣고 앞뒤로 움직이면서 어린이 환자를 위로한다고 상상하면 될 듯합니다.

허거블은 다른 사회 관계에서 인간을 대체하는 용도로 만들지 않았습니다. 사람과 사람 사이 사회적 관계를 강화하기 위한 목적으로 개발됐습니다. 특히 소아 병동에 입원한 어린이가 겪는 스트레스, 불안, 고통을 덜해주는 용도로 도입되고 있어요.

연구자들은 보스턴 아동병원·노스이스턴대학교와 손 잡고 보스턴 아동병원 중환자실과 암 병동에 입원한 3~10세 어린이에게 허거블을 주고 48시간 이상 반응을 살폈다고 합니다. 실험 기간 참가자는 감정 Q센서를 쓰고 피부의 전기 저항과 전위 변화 등 피부 전기활동(EDA)을 측정해 허거블의 유효성 여부를 판별한다고 하네요.

허거블 프로젝트는 개인로봇그룹 내 정수연 연구원이 맡고 있어요. 정 연구원은 MIT 전자공학·컴퓨터과학과를 졸업하고 미디어연구소에서 석사 과정을 밟고 있습니다. 그는 “어린이 환자가 허거블과 소통하고 노는 모습을 통해 의료진은 해당 환자가 고통, 스트레스, 불안 등을 얼마나 느끼는 지를 더 잘 이해하는데 도움을 줄 것이다. 또 환자와 허거블 간 상호작용이 환자 가족에 미치는 영향도 살피고 있다”라고 말했습니다.

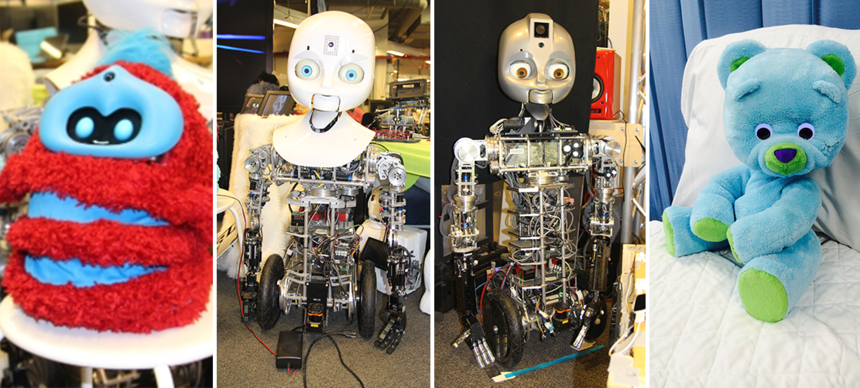

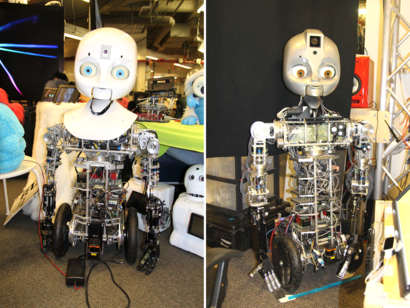

넥시는 위험물 제거용으로 개발된 휴머노이드 로봇입니다. 발이 바퀴라서 평탄한 곳에서 활약하죠. 미국 해군이 개발 지원하고 미디어연구소 개인로봇그룹이 개발했습니다. 매덕스는 넥시를 개량한 모델로 학습이나 인지 능력 면에서 안정적이라고 하네요. 넥시 개량형 모델이라고 봐도 될 듯합니다.

매덕스는 심리학 연구에 활용되고 있습니다. 노스이스턴 대학 심리학과 연구진들은 새로운 사람을 만날 때 얼굴 만지기, 팔짱 끼기, 뒤로 기대기, 손 만지작 거리기 등 행동들이 신뢰를 주지 못한다는 가설을 주장했어요.

연구진이 이 가설을 입증하려면 전문 배우를 고용해 다른 사람 앞에서 말없이 저 행동을 취해야 한다고 하네요. 하지만 사람이 사람과 의사소통할 때 전문 배우라도 자신이 알지도 못하는 사이에 무언의 메시지를 줄 수 있다고 합니다. 실험하다가 하품 나올 수도 있죠. 한마디로 인과관계가 뚜렷이 드러나는 정확한 실험을 수행할 수 없다는 뜻이죠.

미디어 연구소 덕분에 심리학과 연구진들은 전문 사람 배우가 아닌 로봇을 통해 실험을 진행할 수 있었습니다. 매덕스는 사람 못지 않게 풍부한 감정을 상황에 맞게 표현합니다. 로봇공학 전문가가 아니더라도 화면을 통해 로봇이 어떻게 움직이는지 볼 수 있고, 버튼을 누르기만 해도 로봇을 움직이게 할 수 있습니다. 매덕스는 연구진이 머리를 움직이거나 말할 때 그 움직임을 관측하고 실시간으로 따라합니다.

노스이스턴 사회 감정 연구소, 존슨 경영대학원, 코넬대, 그리고 미디어 연구소는 매덕스를 이용해 앞서 말한 심리학 실험을 실시해 그 몸짓들이 신뢰를 주지 못한다는 가설을 입증했다고 하네요.

개인로봇그룹 연구실에는 영화에 출연한 소셜로봇도 있어요. 미디어연구소는 할리우드 특수 효과로 유명한 스탠 윈스턴 스튜디오와 레오나르도를 공동 제작했습니다. 미디어연구소가 가진 최첨단 사회지능 로봇 기술과 스탠 윈스턴 스튜디오가 가진 예술성과 애니매트로닉스(몸체에 기계장치를 넣고 캐릭터 모형을 덧 씌운 후 전기로 움직이게 하는 특수효과 기법) 전문성이 결합된거죠. 아방가르드 예술과 최첨단 기술이 같이 창조했기에 르네상스 시대 예술가이자 과학자, 발명가였던 레오나르도 다빈치를 따라 이름 지었다고 하네요.

레오나르도는 다른 로봇과는 다르게 진짜 동물처럼 생겼습니다. 스탠 윈스턴 스튜디오는 “로봇이 사람이나 개, 고양이를 닮을 필요는 없다. 로봇은 로봇 그 자체 생김새로 존중 받아야 한다”고 밝혔다고 하네요.

얼핏 보기엔 외계종 개처럼 생겼어요. 하지만 그 안에는 복잡한 기계들로 구성되어있습니다. 보통 공장에서 쓰이는 로봇 팔은 상하좌우 그리고 대각선 총 6개 방향으로 움직일 수 있다고 하네요. 한 방향은 한 축이라고 하고, 자유도라고 부르기도 합니다. 그래서 공장로봇팔은 6개의 자유도가 있는 셈이죠. 레오나르도는 69개의 자유도를 가지고 있고 그 중 32개가 얼굴에 들어있습니다. 간단히 말해 정말 다양하게 움직일 수 있다는 말이에요. 사람 얼굴에 근육이 엄청 많은 거에 비할 바는 아니지만, 32개로도 인간처럼 다양한 표정을 지을 수도 있습니다.

복잡한 시스템을 가지고 있지만 걷지는 못합니다. 개처럼 보이는데 걷지도 뛰지도 못하다니 굴욕입니다. 대신 다양한 제스처를 취할 수 있고, 간단하게 사물을 조작할 수도 있습니다. 레오나르도는 77cm로 키가 작은 편이지만 그 어느 로봇보다 다양하고 풍부하게 표현할 수 있습니다.

공장에서 쓰이는 모터랑 레오나르도에 쓰이는 모터는 다르다고 합니다. 공장에서는 크고 강력한 모터를 사용하지만 레오나르도 같이 다양한 기능을 가진 로봇에서는 작고 섬세한 작업을 할 수 있는 모터들이 필요해요. 미디어연구소는 이 점을 고려해 크고 작은 모터들을 제어할 시스템 소프트웨어를 만들었습니다. 레오나르도는 자기가 처한 위치와 고도를 지속적으로 파악하고 기계가 움직이는 기준점이 되는 많은 축들을 제어할 수 있습니다.

레오나르도는 일단 자신을 소개한 사람은 다음에 알아볼 수 있습니다. 예를들어 “안녕, 내 이름은 철현이야”라고 말하면 레오나르도는 눈 왼쪽에 있는 카메라로 제 얼굴을 촬영합니다. 촬영한 이미지에서 배경과 얼굴을 분리해 얼굴 패턴을 분석합니다. 그리고 대화를 통해 들었던 “철현”이라는 이름과 얼굴을 연관 기억합니다. 이 모든 과정이 15초만에 이루어집니다. 제가 방을 비운 사이 레오나르도에게 “철현 어디 갔어?”라고 묻는다면 레오나르도는 방을 둘러보고 보이지 않는다는 표현으로 어깨를 으쓱거립니다.

미디어연구소는 레오나르도를 개량하고 있어요. 기초 틀은 갖춰졌지만 로봇 시야와 감각 분야에서는 더 개선해야 합니다. 인간에게는 간단하지만, 로봇에게는 매우 어려운 일이 많습니다.

미디어연구소는 로봇 시야를 집중 연구하고 있어요. 로봇은 특정 장면에서 주목해야 할 물체에 집중할 수 있어야 합니다. 또 움직이는 물체를 매끄럽게 쫓아가면서 관측할 수 있고 사람과 대화할 때 눈을 바라보고 카메라로 촬영하는 영상에서도 물체 간 거리와 깊이를 가늠할 수 있어야 합니다. 레오나르도는 특정 물체에 집중하고 지속적으로 관측할 수 있습니다. 하지만 완전한 시야 기능을 갖추려면 아직 멀었습니다.

기계 감각 연구도 진행중입니다. 미디어연구소는 온도, 압력, 거리감 등을 레오나르도가 ‘느낄’ 수 있기를 바립니다. 단순히 센서를 외부에 튀어 나오게 장착하지 않고 털과 피부 뒤에 장착해 생물체처럼 보이게 하려 합니다. 사람들이 많이 접촉하는 귀와 손에 센서가 장착되어 있습니다. 점차 전신에 장착한다고 하네요. 미디어연구소는 감각 정보를 레오나르도가 직접 활용할 수 있는 소프트웨어를 개발하고 있습니다.

개인로봇그룹 연구실에 차려진 ‘로봇 박물관’ 앞에 서면 한쪽 자리를 차지하고 있는 빨간색 털복숭이 로봇이 눈에 들어옵니다. 고개를 연신 위 아래로 흔들고 허리는 앞뒤 좌우로 움직이는 건방진 로봇입니다. 미국이니까 힙하다고 표현하겠습니다. 눈에는 함박 웃음을 품고 있기에… 웃는 얼굴에 욕할 수는 없으니까요. 박혜원 미디어연구소 연구원이 이 로봇을 ‘테가’라고 소개하더군요.

테가는 첨단 소셜로봇 플랫폼이라고 합니다. 소트프웨어 개발자, 엔지니어 등 MIT 미디어연구소 소속 연구자들이 공동 개발했어요. 이 요란한 색깔의 털복숭이 로봇은 어린이와 6시간 동안 같이 놀 수 있습니다. 집 안에 비치해 어린이 초기 언어 교육이나 이야기하기 학습에 쓰일 것으로 예상됩니다.

테가 안드로이드 스마트폰으로 세상을 보고 자기 감정을 표현합니다. 스마트폰에 웃거나 찡그리는 등 얼굴 표정을 표시해 비언어 방식으로 감정을 표현합니다. 스마트폰에 내장된 소프트웨어는 테가 행동과 동작 모터를 통제하고 갖가지 센서를 운영합니다. 이마에 붙은 고화질 카메라와 스피커가 표현력을 배가 시킨다고 하네요.

테가는 애니메이션 동작의 기본 원칙 ‘찌그러뜨리기와 늘리기(squash & stretch)’에 기초해 자연스럽고 유기적인 동작을 만들어낸다고 해요. 이는 사물 특유의 재질이나 성질에 의해 찌그러지거나 튀어 오르는 모양을 표현하는 원리를 말합니다.

테가는 5가지 방식으로 자유롭게 움직입니다. 비트 잘 타게 생겼어요. 먼저 머리를 위아래로 끄덕일 수 있습니다. 허리는 전후좌우로 기울이기도 합니다. 전체 몸체를 좌우 움직이거나 위아래로 오르락내리락합니다. 이 5가지 동작을 섞어서 끊김 없이 빠르고 안정되게 행동을 표현하더군요.

로봇은 자동적으로 작동하거나 사람이 스마트폰으로 원격 조종할 수 있습니다. 한번 충전으로 6시간 작동하고요. 혹시나 하는 말이지만 6시간 다되면 허리를 느릿느릿 움직일 수도 있어요. 금강산도 식후경이라고, 밥은 꼭 챙겨줍시다. 테가는 2개월간 보스턴 내 3개 공립학교에서 외국어 교육에 시험 활용한 바 있습니다.

이 로봇은 여러가지 얼굴 표정을 지을 수 있어요. 웃거나 흥분하고 때론 낙담하는 모습을 보이기도 하고요. 표현 가능한 표정을 더 개발하고 있다고 합니다. 미리 녹음한 오디오로 말도 합니다. 또 텍스트를 음성으로 바꾸는 시스템이나 실시간 음성 스트리밍과 음 높이 변조를 통한 스트리밍 기술도 지원한다고 하네요.

관련기사